Bất kỳ ai cũng sẽ bị sốc khi biết lượng dữ liệu được tạo ra mỗi phút trong thế giới ảo theo một báo cáo do doanh nghiệp phần mềm đám mây DOMO công bố. Theo một nghiên cứu của DOMO, dân số Internet xuất bản 511.200 tweet, xem 4.500.000 video YouTube, tạo 277.777 câu chuyện trên Instagram, gửi 4.800.000 gif, thực hiện 9.772 chuyến đi Uber, thực hiện 231.840 cuộc gọi Skype và chuyển hơn 162.037 khoản thanh toán qua thiết bị di động mỗi phút.

Vì hiện nay có một lượng lớn dữ liệu kỹ thuật số được thu thập mỗi phút nên hầu hết các công ty tiến bộ đều mong muốn sử dụng các kỹ thuật tiên tiến để rút ra kết luận quan trọng từ dữ liệu của họ nhằm đưa ra những đánh giá có lợi hơn. Đây là nơi các công nghệ và công cụ khai thác dữ liệu trở nên hữu ích.

1. Khai thác dữ liệu là gì?

Một loạt các kỹ thuật và phương pháp được sử dụng trong khai thác dữ liệu để kiểm tra các tập dữ liệu lớn và rút ra những hiểu biết thương mại. Khai thác dữ liệu là một lĩnh vực đang nổi lên nhanh chóng, bao gồm mọi thứ từ làm sạch dữ liệu đến trực quan hóa dữ liệu về những hiểu biết sâu sắc thu được từ dữ liệu. Nó bắt đầu ngay sau khi dữ liệu được thu thập lần đầu tiên trong kho dữ liệu.

Thường được gọi là "Khám phá tri thức", khai thác dữ liệu là quá trình kiểm tra kỹ lưỡng các bộ dữ liệu lớn từ nhiều lĩnh vực mới phát triển, bao gồm trí tuệ nhân tạo, dữ liệu lớn và học máy. Để giúp doanh nghiệp cải thiện trải nghiệm của khách hàng, dự báo tương lai, hợp lý hóa các quy trình và gia tăng giá trị, quy trình này sẽ tìm kiếm các xu hướng, mô hình, kết nối và những điểm bất thường trong dữ liệu.

Sau đây là các giai đoạn chính của khai thác dữ liệu: Xác định sự bất thường Lập mô hình phụ thuộc Phân loại nhóm Hồi quy Tạo báo cáo 2. Các công cụ hữu ích trong khai thác dữ liệu 2.1. Apache Mahout

Apache Foundation đã tạo ra Apache Mahout, một trong những công cụ khai thác dữ liệu nguồn mở mạnh nhất hiện có, với trọng tâm chính là lọc, phân cụm và phân loại dữ liệu cộng tác. Được viết bằng ngôn ngữ lập trình hướng đối tượng, dựa trên lớp Java, Apache Mahout bao gồm các thư viện Java hữu ích hỗ trợ các chuyên gia dữ liệu thực hiện nhiều tác vụ toán học khác nhau, chẳng hạn như đại số tuyến tính và thống kê.

Sau đây là các tính năng chính của Apache Mahout: Môi trường lập trình đa năng. Thuật toán được xây dựng trước. Phạm vi ứng dụng để phân tích toán học. Bộ xử lý đồ họa (GPU) theo dõi hiệu suất tăng lên.

2.2. Dundas BI

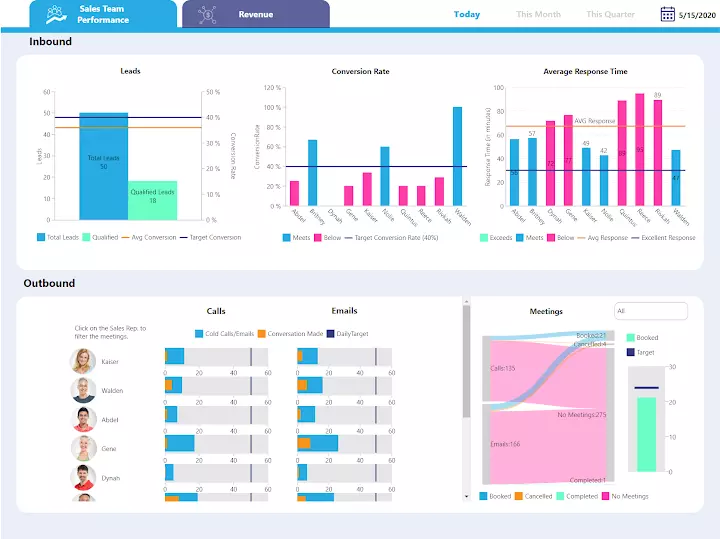

Một trong những giải pháp khai thác dữ liệu hoàn chỉnh nhất để tạo ra những hiểu biết nhanh chóng và cho phép tích hợp nhanh chóng là Dundas BI. Phần mềm khai thác dữ liệu ưu việt sử dụng các kỹ thuật khai thác dữ liệu quan hệ và nhấn mạnh việc tạo ra các cấu trúc dữ liệu được xác định rõ ràng giúp xử lý, phân tích và báo cáo dữ liệu dễ dàng hơn.

Một số tính năng chính của Dundas BI là: Bảng điều khiển mang tính thẩm mỹ. Tính khả dụng của dữ liệu trên nhiều nền tảng. Đánh giá thông tin toàn diện. Báo cáo đáng tin cậy. Loại bỏ yêu cầu về phần mềm bổ sung. Kết hợp các bảng, biểu đồ và đồ thị bắt mắt. 2.3. Teradata

Với kho dữ liệu cấp doanh nghiệp để quản lý và khai thác dữ liệu trơn tru, Teradata, còn được gọi là Cơ sở dữ liệu Teradata, một giải pháp khai thác dữ liệu rất được khuyến khích. Phần mềm khai thác dữ liệu phổ biến nhất trên thị trường chủ yếu được sử dụng để hiểu rõ hơn về dữ liệu quan trọng trong kinh doanh về sở thích của khách hàng, định vị sản phẩm và doanh số bán hàng. Nó có khả năng phân biệt dữ liệu "lạnh" và "nóng".

Các đặc điểm chính của Teradata là: Hoàn hảo cho phân tích kinh doanh hiện đại. Giá cạnh tranh. Áp dụng thiết kế kiến trúc không chia sẻ. Sở hữu bộ nhớ và sức mạnh xử lý trên các nút máy chủ.

2.4. SAS Data Mining

Viện Hệ thống Phân tích Thống kê (SAS) đã tạo ra Công cụ Khai thác Dữ liệu SAS, một phần mềm để quản lý, phân tích và khai thác dữ liệu nâng cao. Công cụ được sử dụng rộng rãi này hoàn hảo cho việc khai thác và tối ưu hóa văn bản. Nó có thể xử lý dữ liệu, khai thác dữ liệu và thực hiện phân tích thống kê để cung cấp cho khách hàng những hiểu biết chính xác giúp tăng tốc và đưa ra quyết định.

Sau đây là một số thuộc tính chính của Công cụ khai thác dữ liệu SAS: Giao diện người dùng (UI). Kiến trúc phân tán đồ họa. Khả năng mở rộng tuyệt vời.

2.5. SPSS Modeler

Sau quyền sở hữu ban đầu của SPSS Inc., International Business Machines Corporation (IBM) đã mua bộ phần mềm SPSS Modeler. Với phần mềm SPSS—hiện là sản phẩm của IBM—người dùng có thể tạo các mô hình dự đoán mà không cần bất kỳ kiến thức lập trình nào bằng cách sử dụng các thuật toán khai thác dữ liệu. Có hai phiên bản của công cụ khai thác dữ liệu được ưa chuộng: IBM SPSS Modeler Professional và IBM SPSS Modeler Premium, bao gồm các công cụ khác để phân tích văn bản và thực thể.

Sau đây là các tính năng chính của IBM SPSS Modeler: Giao diện người dùng hấp dẫn trực quan. Loại bỏ sự phức tạp không cần thiết. Khả năng mở rộng đáng kinh ngạc.

2.6. DataMelt

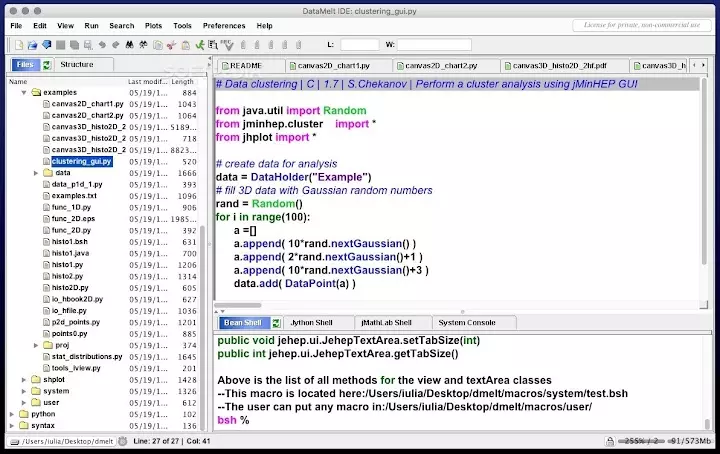

Nền tảng tính toán và trực quan hóa hiện đại được tích hợp vào DataMelt, một trong những công cụ khai thác dữ liệu nguồn mở phổ biến nhất được phát triển bằng Java, giúp đơn giản hóa việc khai thác dữ liệu. Phân tích thống kê và trực quan hóa dữ liệu trong các lĩnh vực xử lý khối lượng dữ liệu lớn, như thị trường tài chính, là những ứng dụng chính của công cụ DataMelt tất cả trong một, tích hợp các thư viện khoa học và toán học mạnh mẽ.

Các thuộc tính đáng chú ý nhất của DataMelt như sau: Cho phép tạo đồ thị 2D và 3D. Khung tương tác. Chạy trên mọi hệ điều hành tương thích với Máy ảo Java (JVM).

2.7. Rattle

Rattle là một ứng dụng khai thác dữ liệu dựa trên GUI, mã nguồn mở, tận dụng khả năng tính toán thống kê mạnh mẽ của ngôn ngữ lập trình R để tạo ra dữ liệu hữu ích, sâu sắc. Người dùng có thể tạo mã trùng lặp cho các hoạt động GUI, kiểm tra nó và mở rộng mã nhật ký mà không có bất kỳ hạn chế nào bằng cách sử dụng tab mã tích hợp của Rattle.

Các đặc điểm chính của công cụ khai thác dữ liệu Rattle là: Các tính năng mở rộng để khai thác dữ liệu. Giao diện người dùng tuyệt vời, được chăm chút kỹ lưỡng. Nguồn mở và miễn phí. Giúp việc duyệt và thay đổi tập dữ liệu trở nên đơn giản.

2.8. Oracle Data Mining

Nền tảng khai thác dữ liệu của Oracle, được hỗ trợ bởi cơ sở dữ liệu Oracle và là một trong những công cụ khai thác dữ liệu đáng tin cậy nhất hiện có, cung cấp cho các nhà phân tích dữ liệu quyền truy cập vào các thuật toán tuyệt vời để phân tích chuyên ngành, phân loại dữ liệu, dự đoán và hồi quy. Điều này cho phép họ tìm ra các mẫu dữ liệu có ý nghĩa có thể được sử dụng để phát hiện gian lận, cải thiện dự đoán thị trường và phát hiện các cơ hội bán chéo.

Ưu điểm chính của công cụ khai thác dữ liệu Oracle là: Các phương pháp khai thác dữ liệu sử dụng các tính năng mạnh mẽ của cơ sở dữ liệu Oracle. Cho phép người dùng kéo và thả tệp vào và ra khỏi cơ sở dữ liệu. Sử dụng SQL hoặc Ngôn ngữ truy vấn có cấu trúc. Khả năng mở rộng chưa từng có.

2.9. Sisense

Sisense, phù hợp cho cả doanh nghiệp nhỏ và lớn, cho phép các nhà phân tích dữ liệu tạo kho lưu trữ bằng cách hợp nhất dữ liệu từ nhiều nguồn. Các tiện ích và chức năng kéo và thả cũng được bao gồm trong ứng dụng khai thác dữ liệu tuyệt vời này, giúp việc tinh chỉnh và phân tích dữ liệu dễ dàng hơn nhiều. Người dùng có thể nhanh chóng tạo báo cáo ở nhiều định dạng, chẳng hạn như biểu đồ hình tròn, biểu đồ thanh và biểu đồ đường bằng cách chọn các tiện ích khác nhau.

Điểm nổi bật của công cụ khai thác dữ liệu Sisense là: Giao diện người dùng mạnh mẽ. Báo cáo mang tính thẩm mỹ. Báo cáo được chia sẻ với toàn bộ tổ chức chỉ bằng một cú nhấp chuột. Môi trường linh hoạt.

2.10. RapidMiner

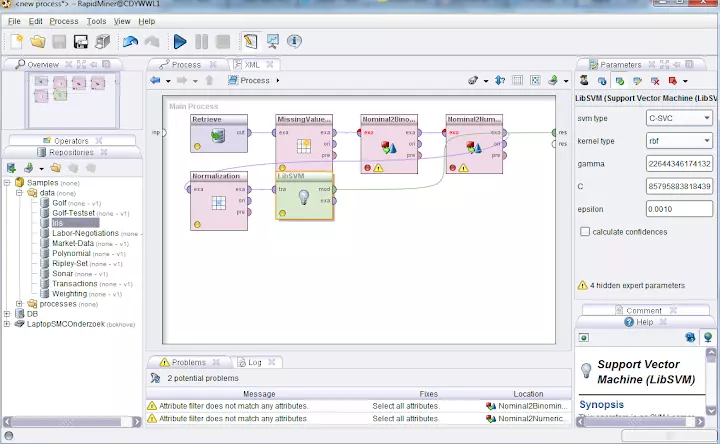

Là một nền tảng khoa học dữ liệu mạnh mẽ và có khả năng thích ứng, RapidMiner cung cấp một khu vực tập trung để khai thác văn bản, phân tích dự đoán, học máy, học sâu và chuẩn bị dữ liệu. Giao diện trực quan thân thiện với người dùng của nó giúp cả chuyên gia kỹ thuật và người mới bắt đầu tạo các quy trình phân tích dễ dàng hơn, loại bỏ yêu cầu về kiến thức lập trình phức tạp.

Một số đặc điểm nổi bật của RapidMiner là: Giao diện kéo và thả để tạo các quy trình liên quan đến phân tích dữ liệu. Hỗ trợ nhiều nguồn dữ liệu, chẳng hạn như lưu trữ đám mây, tệp Excel và cơ sở dữ liệu. Cung cấp các phương pháp và thuật toán học máy tiên tiến để phân loại, phân cụm và mô hình dự đoán. Cung cấp tài nguyên để tối ưu hóa các tham số và thực hiện xác thực chéo để đảm bảo độ chính xác của mô hình. Tích hợp với Python và R và có thể được mở rộng bằng các plugin để bổ sung thêm nhiều tính năng hơn.

2.11. KNIME

Với KNIME (Konstanz Information Miner), người dùng có thể thiết kế các luồng dữ liệu trực quan, thực hiện một số bước phân tích nhất định hoặc tất cả các bước đó và kiểm tra các phát hiện bằng cách sử dụng các mô hình và chế độ xem tương tác. KNIME là một nền tảng nguồn mở để phân tích, báo cáo và tích hợp dữ liệu. KNIME đặc biệt nổi tiếng với thiết kế đường ống dữ liệu mô-đun, cho phép nó tích hợp nhiều thành phần khai thác dữ liệu và học máy.

Các đặc điểm quan trọng bao gồm: Cung cấp giao diện lập trình trực quan với mã thấp hoặc không có mã. Có thể tích hợp với nhiều nguồn và loại dữ liệu. Thông qua các nút tùy chỉnh hoặc tiện ích mở rộng KNIME, người dùng có thể thêm các tính năng. Tạo điều kiện hợp tác và trao đổi về quy trình làm việc. Cung cấp nhiều lựa chọn công cụ để khai thác văn bản, phân tích hình ảnh, học máy và phân tích thống kê.

2.12. Orange

Orange là bộ công cụ phần mềm nguồn mở bao gồm nhiều công cụ khai thác dữ liệu, học máy và trực quan hóa. Nó có giao diện lập trình trực quan giúp trực quan hóa dữ liệu động và phân tích dữ liệu nhanh chóng, mang tính thăm dò, định tính. Orange dân chủ hóa hoạt động phân tích dữ liệu bằng cách được thiết kế vừa thân thiện với người dùng vừa đủ mạnh mẽ cho các chuyên gia, giúp nhiều đối tượng hơn có thể tiếp cận dễ dàng hơn.

Trong số các đặc điểm đáng chú ý của Orange là: Chức năng kéo và thả cho các thành phần phân tích dữ liệu trong giao diện người dùng dễ sử dụng. Cung cấp nhiều lựa chọn tiện ích để trực quan hóa dữ liệu phức tạp. Bao gồm các tiện ích được tạo sẵn cho một loạt nhiệm vụ liên quan đến học máy. Cho phép người dùng có kinh nghiệm hơn tạo tập lệnh Python. Người dùng có thể bổ sung các tiện ích khai thác văn bản, tin sinh học và các lĩnh vực khác để tăng khả năng của nó.

2.13. H2O

H2O là một nền tảng mã nguồn mở, có khả năng mở rộng để phân tích dự đoán và học máy, có thể chạy trên các máy tính phân tán và trong bộ nhớ. Nó cho phép xây dựng các mô hình học máy trên các tập dữ liệu lớn và dễ dàng triển khai các mô hình đó trong môi trường công nghiệp. Mặc dù cơ sở mã cốt lõi của H2O được viết bằng Java, nhưng nó có thể truy cập được thông qua API Python, R và Scala, khiến nó phù hợp với nhiều nhà phát triển và nhà khoa học dữ liệu.

Các đặc điểm quan trọng bao gồm: Được thiết kế có tính đến khả năng mở rộng theo chiều ngang để chứa các tập dữ liệu lớn. Tuân thủ phần lớn các kỹ thuật học máy phổ biến. Cung cấp giải pháp mô hình chấm điểm trong sản xuất dễ dàng triển khai. Điều chỉnh siêu tham số và lựa chọn mô hình được thực hiện thông qua học máy tự động. Có thể được tích hợp thông qua các đầu nối Tableau, Spark và Hadoop với môi trường dữ liệu lớn.

2.14. Zoho Analytics

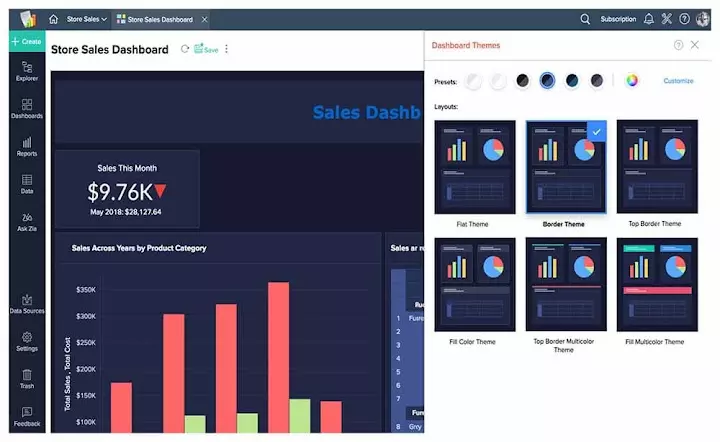

Với sự trợ giúp của nền tảng phân tích dữ liệu và BI thân thiện với người dùng của Zoho Analytics, bạn có thể nhanh chóng tạo bảng chỉ số toàn diện và trực quan hóa dữ liệu hấp dẫn về mặt thẩm mỹ. Được thiết kế dành cho cả doanh nghiệp nhỏ và lớn, nó hợp lý hóa quy trình phân tích dữ liệu và giúp người dùng tạo bảng điều khiển và báo cáo một cách đơn giản.

Các đặc điểm quan trọng bao gồm: Giao diện đơn giản không cần hỗ trợ CNTT để tạo báo cáo và bảng chỉ số. Có thể nhập dữ liệu từ một số nguồn, chẳng hạn như cơ sở dữ liệu, nguồn cấp dữ liệu trực tuyến, ứng dụng kinh doanh và tệp. Cung cấp các công cụ cộng tác và chia sẻ nhóm. Zia, trợ lý Zoho được hỗ trợ bởi AI, có thể đáp ứng các yêu cầu ngôn ngữ tự nhiên với thông tin chi tiết nhanh chóng. Cung cấp cho các trang web và ứng dụng khả năng kết hợp bảng điều khiển và báo cáo phân tích. Hy vọng rằng những chia sẻ của BAC sẽ giúp ích cho bạn. Đừng quên đón đọc các bài viết mới nhất được cập nhật tại BAC's Blog bạn nhé.