Đây là góc nhìn cá nhân của mình. Bài này mình viết luyên thuyên nên sẽ dài đó, cần cân nhắc trước khi đọc để không buồn ngủ nhé. Gẹt gô.

1. Mở đầu

Nào, dạo gần đây có gì hot nhỉ? ChatGPT everywhere.

Thật sự là không chỉ có Facebook, mà các trang báo lớn, các blog cũng đều đưa tin về con chatbot được ví như "Siêu AI" này vậy, lướt một tí là thấy, lướt một tí là thấy. Và theo quan điểm của mình, thì có lẽ truyền thông đang thổi phồng hơi quá về con chatbot này rồi thì phải 🤔🤔🤔 Thực ra cơ chế lõi (mà cũng là nền tảng cho các Large Language Model (LLM)) được công bố từ lâu rồi. Thế nên, bài viết hôm nay thì mình sẽ tản mạn một chút về con chatbot này, cũng như chia sẻ quan điểm của mình về nó. Oke gẹt gô.

2. Siêu AI (Artificial Super-Intelligence) là gì?

Mình thấy một số tờ báo tung hô ChatGPT là một Siêu AI, vậy Siêu AI là gì, và nó có đúng nó là một Siêu AI không nhỉ?

Trước tiên, nếu dựa vào khả năng của AI để phân loại thì chúng ta có thể chia AI làm 3 loại chính:

- Narrow AI (hay còn gọi là Weak AI, viết tắt là ANI): là những AI có khả năng thực hiện một tác vụ nhất định. Các mô hình AI thuộc dạng này sẽ mô phỏng lại một hành vi nào đó của con người thông qua những model được thiết kế sẵn và học từ một tập dữ liệu to. Ngày nay, phần lớn các ứng dụng AI đều thuộc dạng này, từ các hệ thống gợi ý (recommendation system) tới các trợ lí ảo (như Siri, Alexa, Google Assistant, v.v.) và còn nhiều thứ khác nữa. Những AI này hiện nay vẫn nằm trong tầm kiểm soát của con người, tức là chúng vẫn đang thực hiện những tác vụ cụ thể mà con người đặt ra, chưa có nhận thức sâu và chưa có khả năng thực hiện đa tác vụ như một con người.

- General AI (hay còn gọi là Strong AI, viết tắt là AGI): là những AI có khả năng thực hiện cùng lúc nhiều tác vụ nhất định (như con người vậy đó). Ngoài ra, khi AI đã đạt tới "cảnh giới" này thì AI bắt đầu có nhận thức về những gì nó đang làm, cũng như bắt đầu có những hành vi, biểu hiện giống con người (ví dụ như có khả năng tự học, phân tích lựa chọn, trao đổi, đưa ra ý kiến, v.v.). Nói chung là đến mức này thì AI thực sự "thông minh" rồi đấy. Hiện nay, "công dân robot" đầu tiên trên thế giới Sophia đã tiệm cận khả năng này (tất nhiên chưa được trơn tru mượt mà như con người rồi).

- Super AI (viết tắt là ASI): là những AI mang tính siêu việt, tức là khả năng thực hiện đa tác vụ của chúng vượt trội hơn cả con người nhờ vào nguồn dữ liệu khổng lồ nó thu thập được, cũng như những tiến bộ về khoa học công nghệ. Ngoài ra, khả năng tự học, biểu diễn cảm xúc cũng như suy nghĩ, khả năng quyết định, blablabla của chúng cũng trở nên vượt trội, có thể vượt ra ngoài tầm kiểm soát của con người (Con Ultron trong phim Avengers là một ví dụ điển hình của thể loại này).

Từ những điều trên, theo mình thì hiện nay, mới chỉ có "công dân robot" Sophia là đang tiệm cận mức General AI thôi, còn cả một quá trình dài thật dài nữa mới đạt tới cảnh giới siêu AI. ChatGPT thì cũng ghê đấy, nhưng vẫn chưa đạt tới cảnh giới "General AI" đâu. Nếu ChatGPT được gọi là siêu AI thì những AI đạt tới cảnh giới General AI, hay xa hơn là super AI thì sẽ được gọi là gì nhỉ 🤔🤔🤔, siêu AI pro max ultra à?

Và thực ra, cái "gốc" của ChatGPT là một cơ chế đã được công bố từ năm 2015 rồi. Cơ chế đó là......

3. Attention, cơ chế lõi của các mô hình LLM, là gì?

3.1. Attention

Attention là một bài hát nổi tiếng của ca sĩ Charlie Puth. Xong 🤣

Đùa thôi, Attention (trong Deep Learning) là một cơ chế (mechanism) được ra đời vào năm 2015 bởi Bahdanau. Cơ chế này được giới thiệu qua rất nhiều bài blog rồi, vậy nên mình chỉ nói lại sơ lược một chút thôi nhé.

Trước khi cơ chế Attention ra đời, các mô hình seq2seq với 2 khối encoder và decoder (tạo thành từ các lớp RNN) được sử dụng để thực hiện bài toán Neural Machine Translation (NMT). Đã là "dịch" thì phải mã hóa mọt chuỗi từ ngôn ngữ này qua ngôn ngữ khác. Vì vậy:

- Encoder sẽ có nhiệm vụ xử lí thông tin đầu vào và mã hóa những thông tin này thành những feature vectors. Những feature vectors này sẽ trở thành đầu vào của tầng Decoder.

- Decoder sẽ có nhiệm vụ dựa vào đầu ra từ tầng Encoder để tìm ra phân phối xác suất từ các feature vectors, từ đó tìm ra label tương ứng. Nói nôm na là ánh xạ dữ liệu từ miền này qua miền khác.

Sử dụng RNN sẽ rất hiệu quả đối với những câu văn ngắn, tuy nhiên, với những câu văn dài thì sử dụng RNN sẽ dễ bị hiện tượng vanishing gradient, chưa kể còn có thể bị bỏ quên thông tin nào đó. Lúc đó thì LSTM lại có thể giải quyết được vấn đề này. Tuy nhiên thì LSTM lại tốn nhiều thời gian để huấn luyện và không thể thực hiện transfer learning được. Vì vậy, cơ chế Attention ra đời như là "cứu tinh" của bài toán này vậy.

Đúng như tên gọi , cơ chế này sẽ "tập trung" toàn bộ thông tin từ tầng Encoder về một mối để taọ ra một context vector thay vì chỉ sử dụng vector trạng thái ẩn của state cuối cùng để tạo ra vector biểu diễn cho decoder. Điều này sẽ khắc phục các nhược điểm của RNN, bao gồm việc bỏ sót thông tin (vì khi encode một lượng lớn thông tin trong một vector biểu diễn nhỏ thì chắc chắn sẽ có sự bỏ sót thông tin rồi). Chi tiết thuật toán thì mọi người có thể tìm đọc trong paper gốc nhé.

3.2. Transformer, kẻ kế thừa vĩ đại

Sau sự ra đời của cơ chế Attention, thì một model đã ra đời đã tạo ra bước ngoặt biến đổi thế giới NLP. Đó chính là Transformer, được giới thiệu trong bài báo với cái tên huyền thoại: Attention is all you need. Những đặc điểm sau đã giúp Transformer "một bước lên mây" và trở thành kiến trúc được rất nhiều "hậu bối" áp dụng (trong đó có cả nhân vật chính của bài này):

- Thứ nhất đó là ứng dụng thành công Attention, cụ thể là cơ chế self-attention. Theo đó, self-attention là cơ chế giúp cho encoder có thể "nhìn" được các từ xung quanh trong khi đang mã hoá một từ cụ thể, do đó, có thể hiểu được sự liên quan giữa các từ trong 1 câu bất kể khoảng cách có xa tới đâu.

- Thứ hai đó là sự kết hợp giữa ưu điẻm của CNN và ưu điểm của RNN, đó là tính toán song song bằng cách học chuỗi hồi tiếp với cơ chế tập trung, đồng thời mã hoá vị trí của từng phần tử trong chuỗi (thay vì xử lí các phần tử trong chuỗi một cách tuần tự). Điều này giúp Transformer có thể tận dụng được khả năng của GPU và giúp tiết kiệm thời gian huấn luyện hơn.

Kiến trúc cũng như cách thức hoạt động của mô hình này thì mọi người có thể tham khảo lại tại paper gốc, hoặc các blog khác nhé.

Có thể nói, cơ chế Attention và kiến trúc Transformer đã mở ra một thời đại mới cho các mô hình LLM. Một trong số đó có thể kể đến GPT-3, mô hình được coi là "bố" của ChatGPT. GPT-3 là thế hệ thứ 3 của "dòng họ" GPT, được phát triển bởi OpenAI. GPT-3 ứng dụng cơ chế Attention để tạo ra mô hình có khả năng sinh ngôn ngữ giống như người thật. Nguyên lí hoạt động của GPT và ChatGPT thì để bài khác nhé.

Nhìn chung, về mặt kĩ thuật, có thể nói ChatGPT không phải là một kiến trúc đủ mới để tạo bước ngoặt hay tiếng vang lớn như "ông tổ" Transformer đã từng. Vậy tại sao con Chatbot này lại hot đến vậy?

4. Tại sao ChatGPT lại hot hòn họt đến vậy?

4.1. Sao lại hot vậy nhỉ?

Theo góc nhìn của mình thì có những lí do sau:

- Thứ nhất, nó được "thừa hưởng" những tinh hoa của ông bố nó, là GPT-3. Việc được thừa hưởng từ một model có tới 175 tỉ tham số đã đem lại cho ChatGPT một lợi thế đáng kể trong khả năng sinh ngôn ngữ để giao tiếp như người thật.

- Thứ hai, đó là việc OpenAI đã "liều" khi thương mại hoá con chatbot mà ngay cả chính những người trong cuộc coi là một sản phẩm "tình thế" để giải quyết các khó khăn. Tại sao lại gọi là "liều"? Vì các ông lớn, đặc biệt là Google, nơi khai sinh ra kiến trúc Transformers cũng đã có một con chatbot cho riêng mình. Tuy nhiên, họ đã không công bố vì lo ngại vấn đề nội dung độc hại, hoặc độ chính xác của thông tin do con chatbot của họ có thể sinh ra. Cái này giống như là "ông không làm thì để tôi" vậy đó.

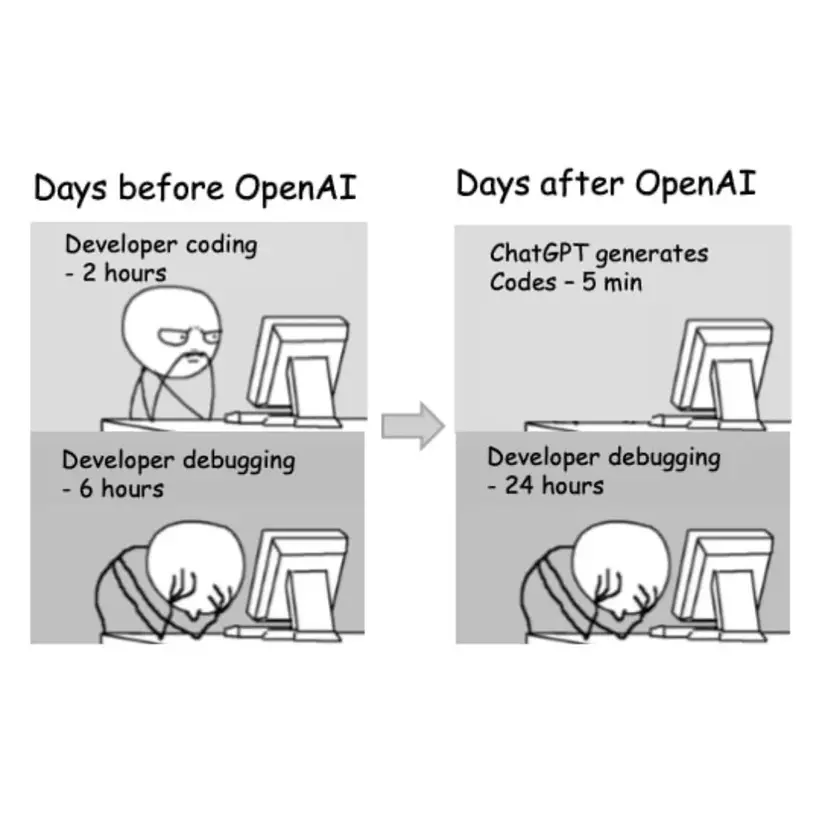

- Thứ ba, đó là do yếu tố truyền thông. Mọi người có công nhận là những nội dung về ChatGPT đang xuất hiện dày đặc trên các trang báo không? Và từ lúc ChatGPT trở nên nổi tiếng thì hàng loạt meme được ra đời, làm mình cũng không biết đâu là đoạn chat thật, đâu là sản phẩm của Photoshop nữa. Thế nên, tò mò ắt sẽ phải tìm hiểu, và vô hình chung đã làm cho chatbot này trở nên viral hơn thôi.

Update: Ngày 06/02/2023 thì Google đã công bố, chatbot Bard của họ (được "thừa hưởng" từ LaMDA, cũng là một LLM do Google xây dựng nên) đang trong quá trình thử nghiệm và đánh giá, sắp tới sẽ được công bố rộng rãi tới người dùng. Đồng thời, Baidu cũng đã công bố kế hoạch phát triển chatbot của riêng họ mang tên Ernie Bot. Chà, đại chiến chatbot sắp bùng nổ rồi đây... Thế là AI ngày càng được phổ biến một cách rôngj rãi tới mọi người rồi. Nhưng......

4.2. ChatGPT và Google Search

Một khía cạnh khác mà mình muốn chia sẻ quan điểm, đó là việc nhiều người coi ChatGPT là công cụ thay thế Google Search. Thừa nhận đi, bạn có cảm thấy kích thích khi thông tin chúng ta tìm kiếm được "trả lời" ngay tức khắc, và đến từ một con chatbot có khả năng nói chuyện một cách khá mượt mà như một người bạn không? (Đúng nhận, sai cãi nào 🤣).

Tuy nhiên cần phải làm rõ, là Google Search sẽ giúp chúng ta tự chọn lọc thông tin khi chúng ta tìm hiểu về cái gì đó. Còn khi chúng ta sử dụng ChatGPT để giải đáp thắc mắc, chúng ta thường sẽ có xu hướng ít khi kiểm tra lại thông tin vì chúng ta đã có một niềm tin mãnh liệt, rằng "AI này luôn đúng" và việc một con chatbot có khả năng trò chuyện như người bình thường cung cấp thông tin một cách trực tiếp sẽ làm chúng ta bị "lười" đi đấy.

Điều này nguy hiểm nhé, vì chính những nhà phát triển cũng khuyến cáo rằng thông tin do ChatGPT đưa ra có thể sai, và không nên quá phụ thuộc vào nó, đặc biệt là khi hiện nay có rất nhiều bạn học sinh, sinh viên sử dụng công cụ này để gian lận trong các bài kiểm tra, khóa luận, v.v.

4.3 Điểm yếu của ChatGPT

Ai cũng biết về điểm mạnh rồi, thế bây giờ nói về điểm yếu của chatbot này nhé.

Đầu tiên đó là việc chatbot này có thể cung cấp thông tin sai sự thật. Bà Mira Murati, CTO của OpenAI, "nữ tướng" đứng sau thành công của ChatGPT đã thừa nhận điều này. Theo đó, vì dựa trên công nghệ RLHF (Học tăng cường dựa theo phản hồi của người dùng) mà người dùng có thể cung cấp thông tin sai lệch cho chatbot, khiến cho chatbot có thể học theo.

Thứ hai, vốn dĩ ChatGPT vẫn chỉ là một Narrow AI như đã nói ở trên, việc cập nhật thông tin theo thời gian thực để huấn luyện mô hình là một trở ngại lớn. Theo đó, nguồn dữ liệu dùng để huấn luyện chatbot này mới được cập nhật đến năm 2021, do đó, nếu bạn hỏi thông tin về chiếc Samsung Galaxy S23 thì chưa chắc nó đã trả lời đúng đâu.

Thứ ba, đó là vấn đề bảo mật thông tin. Các doanh nghiệp muốn dùng ChatGPT thì phải cung cấp thông tin cho chatbot này (vẫn là RLHF), vậy nên, chẳng ai muốn thông tin nhạy cảm của công ti mình bị bại lộ cho toàn thế giới biết cả.

Và còn hàng loạt những điểm yếu khác, vì ChatGPT hiện tại vẫn chưa có khả năng độc lập suy nghĩ như nhiều người vẫn tưởng.

5. Kết luận

Nói nhiều nói dài mãi mới đến kết luận 🤣 Tính mình thích nói dài nên viết cũng dài luôn.

Đối với mình, một kỹ sư AI, việc AI được phổ biến rộng rãi tới người dùng là một điều tốt, sẽ giúp cho mọi người có thể ứng dụng những lợi ích của AI vào trong công việc hằng ngày. Tuy nhiên có những điều mình thấy không ổn:

- Thứ nhất là truyền thông đang thổi phồng về những gì ChatGPT đang làm được.

- Nhiều người lại đang phụ thuộc vào con chatbot này, cũng như có nhiều người lợi dụng con chatbot này để làm nhưng việc sai trái. Vì vậy, cần phải có cái nhìn đúng đắn về nó, cũng như các mô hình, ứng dụng AI nói chung để chúng ta sử dụng nó một cách có ích, chứ không phải là phụ thuộc nó và lợi dụng nó.

Vì vậy, hãy có cái nhìn đúng đắn về AI nói chung, và ứng dụng AI một cách thực tế và đúng đắn nhất để AI trở thành "trợ lí" đắc lực cho cuộc sống của chúng ta.

Mọi người có chia sẻ, góp ý gì thì cho mình biết nhé. Cheers.

Tài liệu tham khảo:

Sách: Dive into Deep Learning, chương 10, 11

What Are the Types of Artificial Intelligence: Narrow, General, and Super AI Explained